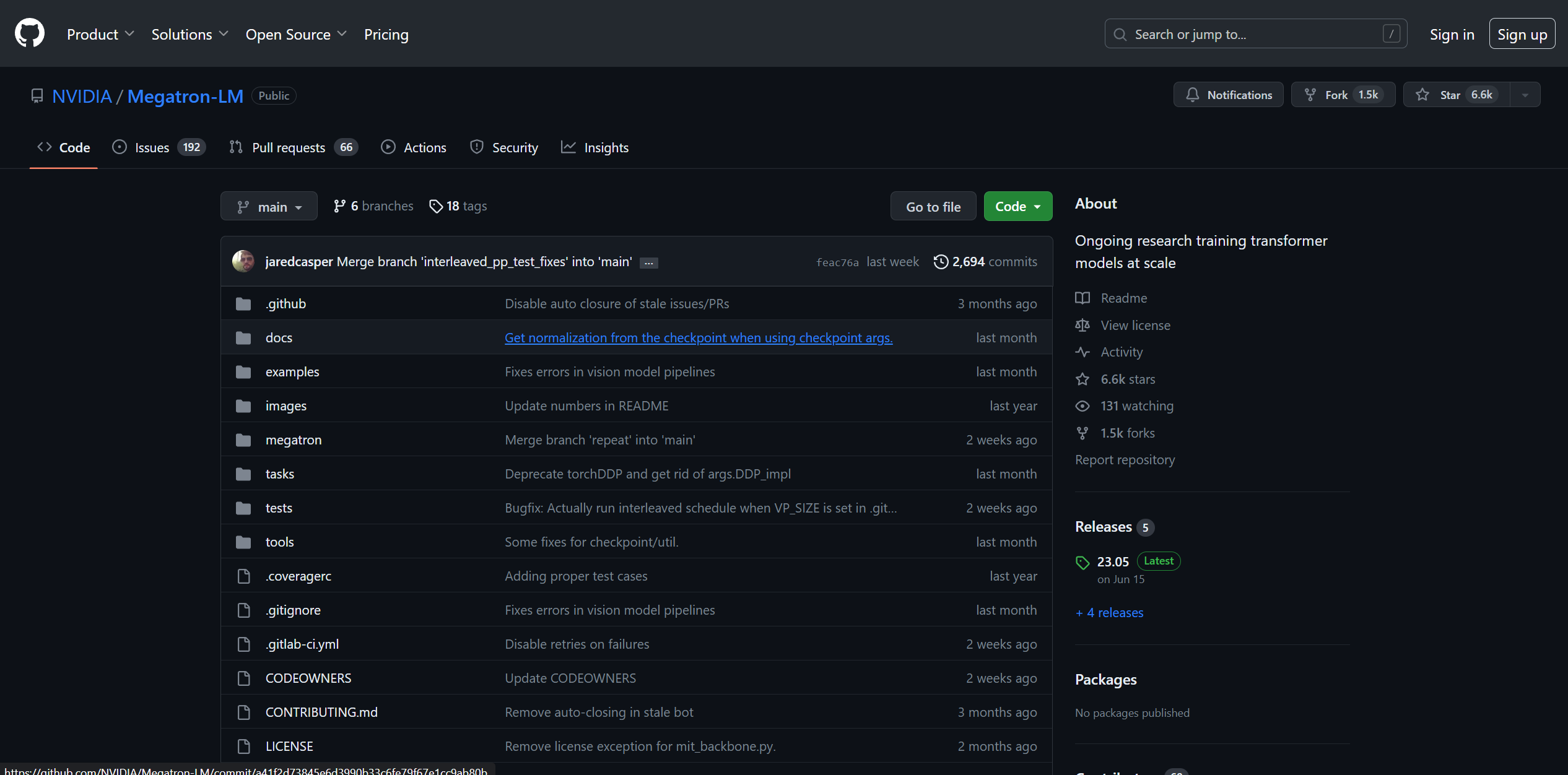

官方网站:立即使用

威震天 LM 功能

- 威震天(Megatron)提供三个迭代版本(1、2 和 3),是由 NVIDIA 应用深度学习研究团队开发的一款强大且高性能的 Transformer 模型。 该计划旨在推进大型 Transformer 语言模型领域的研究。 威震天旨在促进这些模型的大规模训练,使其成为众多应用的宝贵资产。

主要亮点

- 高效的模型并行性:Megatron 结合了用于张量、序列和流水线处理的模型并行技术。 这种效率确保了平滑和可扩展的模型训练,尤其是在涉及 GPT、BERT 和 T5 等大型 Transformer 模型的场景中。

- 混合精度:威震天采用混合精度来增强大规模语言模型的训练。 此策略可优化硬件资源的利用率,从而实现更高效的性能。

使用威震天的项目

- 威震天已被应用于广泛的项目中,展示了其多功能性和对各个领域的贡献。 一些值得注意的项目包括:

- 使用威震天对 BERT 和 GPT 的研究

- BioMegatron:生物医学领域语言模型的进步

- 用于开放领域问答的神经检索器的端到端训练

- 大规模多参与者生成对话建模

- 本地知识驱动的对话代理

- MEGATRON-CNTRL:利用外部知识进行可控的故事生成

- RACE 阅读理解数据集排行榜的进展

- 从合成数据训练问答模型

- 用少镜头指令提示检测社会偏见

- 探索用于解毒语言模型的领域自适应训练

- 利用 DeepSpeed 和 Megatron 训练 Megatron-Turing NLG 530B

尼莫威震天

- 威震天在NeMo Megatron中得到了应用,NeMo Megatron是一个全面的框架,旨在解决构建和训练具有数十亿甚至数万亿个参数的高级自然语言处理模型的复杂性。 该框架对于从事大型NLP项目的企业特别有利。

可扩展性

- 威震天的代码库装备精良,可以有效地训练拥有数千亿个参数的大规模语言模型。 这些模型在各种 GPU 设置和模型大小之间表现出可扩展性。 该范围包括 GPT 模型,参数范围从 10 亿到惊人的 1 万亿不等。 可扩展性研究利用了 NVIDIA 的 Selene 超级计算机,涉及多达 3072 个 A100 GPU,用于最广泛的模型。 基准测试结果展示了令人印象深刻的线性缩放,强调了威震天的性能能力。

声明:本站部分文章来源于网络,如有侵犯您的合法权益,请您即时与我们联系,我们将在第一时间处理。如需转载本站文章,请在转载时标明出处并保留原文链接,否则我们将保留追究法律责任的权利。