什么是稳定扩散?

Stable Diffusion 是一种 AI 模型,可根据文本输入生成图像。比方说,如果你想生成姜饼屋的图像,你可以使用如下提示:

姜饼屋,西洋镜,焦点,白色背景,吐司,脆麦片

AI 模型将生成与提示匹配的图像:

有类似的文本到图像生成服务,如 DALLE 和 MidJourney。为什么要稳定扩散?稳定扩散的优点是

- 开源:许多爱好者创建了免费且功能强大的工具。

- 专为低功耗计算机设计:运行免费或便宜。

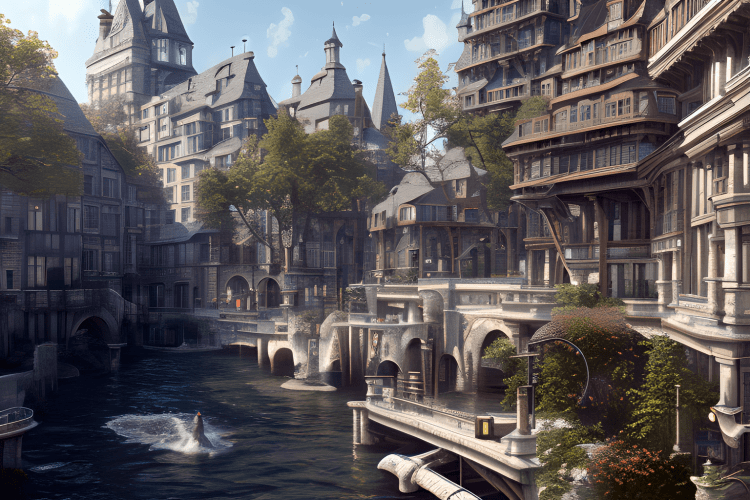

我可以使用 Stable Diffusion 生成什么样的图像?

天空是极限!这里有些例子。

动漫风格

逼真度

景观

幻想

艺术风格

给我报名!如何开始生成图像?

在线生成器

对于绝对的初学者,我建议使用免费的在线生成器。转到列表中的网站之一,输入上面的示例提示,您就可以开始工作了!

高级图形用户界面

免费在线生成器的缺点是功能非常有限。

如果您不再需要它们,您可以使用更高级的 GUI(图形用户界面)。我使用 AUTOMATIC1111,这是一个功能强大且受欢迎的选择。请参阅快速入门指南以在 Google Colab 云服务器中进行设置。

如果您拥有至少 4GB VRAM 的不错的 NVIDIA GPU,那么在您的 PC 上运行也是一个不错的选择。请参阅 Windows 和 Mac 安装指南。

为什么要使用高级 GUI?一整套工具任你使用

- 高级提示技术

- 使用 Inpainting 重新生成图像的一小部分

- 根据输入图像生成图像(图像到图像)

- 通过告诉指令来编辑图像。

如何建立一个好的提示符?

制作一个好的提示需要学习很多东西。但最基本的是尽可能详细地描述你的主题。确保包含强大的关键字来定义样式。

使用提示生成器是学习分步过程和重要关键字的好方法。对于初学者来说,学习一套强大的关键字及其预期效果是必不可少的。这就像学习一门新语言的词汇。您还可以在此处找到关键字和注释的简短列表。

生成高质量图像的捷径是重复使用现有提示。前往提示收藏,选择您喜欢的图像,然后窃取提示!缺点是你可能不明白为什么它会生成高质量的图像。阅读注释并更改提示以查看效果。

或者,使用像 Playground AI 这样的图像收集网站。选择您喜欢的图像并重新混合提示。但这可能就像大海捞针一样寻找高质量的提示。

将提示视为起点。修改以满足您的需要。

建立良好提示的经验法则

两条规则:(1) 详细而具体,(2) 使用强大的关键词。

详细和具体

尽管 AI 突飞猛进,但 Stable Diffusion 仍然无法读懂你的想法。您需要尽可能详细地描述您的形象。

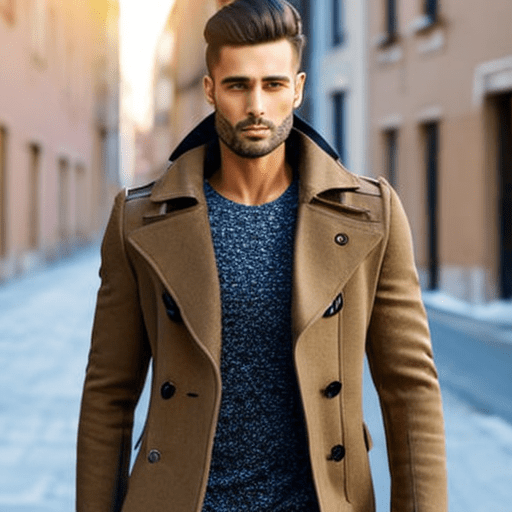

假设您想生成一张街景中的女性照片。一个简单的提示

街上的女人

给你这样的图像:

好吧,您可能不希望生成祖母,但这在技术上符合您的提示。你不能责怪稳定扩散……

所以相反,你应该写更多。

一位年轻的女士,棕色的眼睛,头发上的亮点,微笑,穿着时尚的商务休闲装,坐在外面,安静的城市街道,边缘照明

看到巨大的差异。因此,努力提高你的提示技能吧!

使用强大的关键字

有些关键字比其他关键字更强大。例子是

- 名人的名字(例如 Emma Watson)

- 艺术家姓名(如梵高)

- 艺术媒介(例如插图、绘画、照片)

小心使用它们可以将图像引导到您想要的方向。

您可以在构建提示的基础知识中了解有关提示构建和示例关键字的更多信息。

想作弊?像做作业一样,可以使用ChatGPT来生成提示!

这些参数是什么,我应该更改它们吗?

大多数在线生成器允许您更改一组有限的参数。下面是一些重要的:

- 图像大小:输出图像的大小。标准尺寸为 512×512 像素。将其更改为纵向或横向尺寸会对图像产生很大影响。例如,使用纵向尺寸生成全身图像。

- 采样步骤:至少使用 20 个步骤。如果您看到模糊的图像,请增加。

- CFG 比例:典型值为 7。如果您希望图像更符合提示,请增加。

- 种子值:-1 生成随机图像。如果您想要相同的图像,请指定一个值。

查看其他设置的建议。

我应该生成多少图像?

测试提示时,您应该始终生成多个图像。

我在对提示进行较大更改时一次生成 2-4 张图像,以便加快搜索速度。在进行小的更改以增加看到可用内容的机会时,我会一次生成 4 个。

某些提示仅在一半或更少的时间内有效。因此,不要根据一张图片注销提示。

什么是图像到图像?

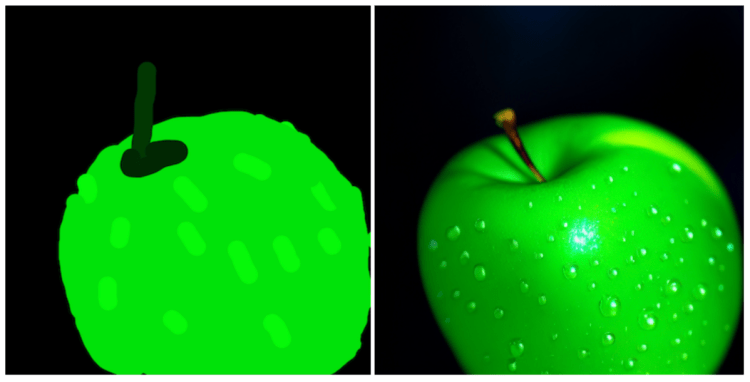

图像到图像根据输入图像和提示生成图像。

图像到图像(或简称 img2img)将 (1) 图像和 (2) 提示作为输入。您不仅可以使用提示,还可以使用图像来指导图像生成。

事实上,您可以将文本到图像视为图像到图像的一种特殊情况:它只是带有随机噪声输入图像的图像到图像。

Img2img 是一种被低估的技术。了解如何使用 img2img 制作专业绘图和卡通化照片!

修复图像缺陷的常用方法

当您看到在社交媒体上分享的令人惊叹的 AI 图像时,它们很可能已经过一系列后期处理步骤。我们将在本节中介绍其中的一些。

面部修复

左:原始图像。右:面部修复后。

在 AI 艺术家社区中众所周知,Stable Diffusion 不擅长生成人脸。很多时候,生成的面孔有伪影。

我们经常使用经过训练的图像 AI 模型来恢复人脸,例如 CodeFormer,AUTOMATIC1111 GUI 已内置支持。查看如何打开它。

您知道修复眼睛的 v1.4 和 v1.5 模型有更新吗?查看如何安装 VAE。

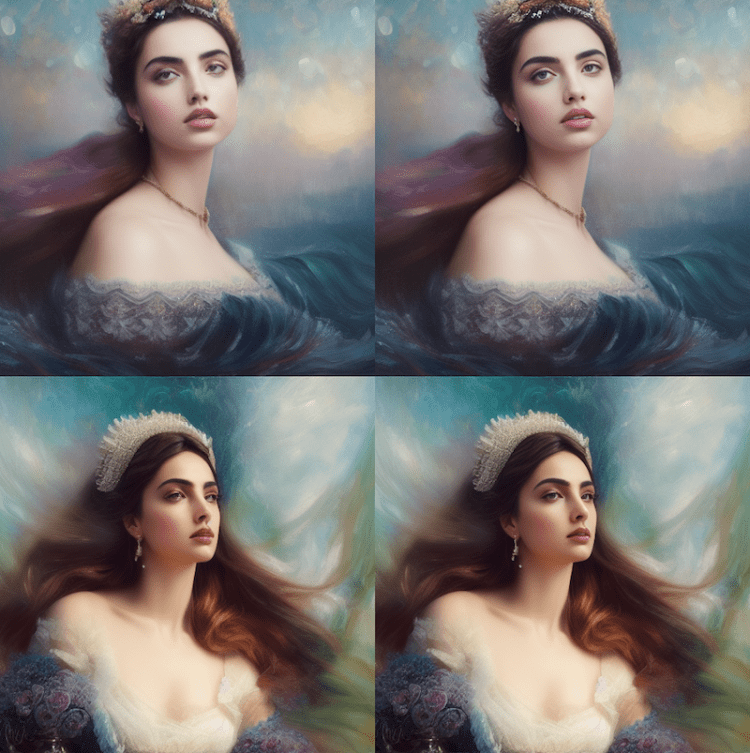

通过修复修复小瑕疵

第一次尝试很难得到你想要的图像。更好的方法是生成具有良好构图的图像。然后用修补修复缺陷。

下面是修复前后的图像示例。在 90% 的时间里使用原始提示进行修复工作。

左:有缺陷的原始图像。右:面部和手臂通过修复修复。

还有其他技术可以解决问题。阅读有关解决常见问题的更多信息。

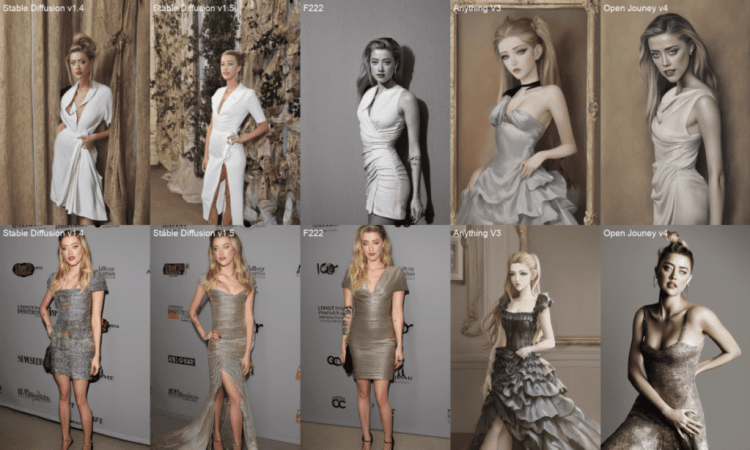

什么是定制模型?

Stability AI 及其合作伙伴发布的官方模型称为基础模型。基本模型的一些示例是 Stable Diffusion 1.4、1.5、2.0 和 2.1。

自定义模型是从基础模型中训练出来的。目前,大多数模型都是从 v1.4 或 v1.5 开始训练的。他们接受额外数据的训练,以生成特定样式或对象的图像。

定制模型只有天空才是极限。它可以是动漫风格、迪士尼风格、另一个人工智能的风格。你说出来。

以下是 5 种不同型号的比较。

由 5 种不同模型生成的图像。

合并两个模型以创建介于两者之间的样式也很容易。

我应该使用哪种型号?

如果您刚开始,请坚持使用基本模型。有很多值得学习和玩耍的东西可以让你忙上几个月。

基本模型的两个主要组是 v1 和 v2。v1 型号为 1.4 和 1.5。v2 型号为 2.0 和 2.1。

您可能认为您应该从较新的 v2 模型开始。人们仍在努力弄清楚如何使用 v2 模型。v2 的图像不一定比 v1 的好。

如果您是 Stable Diffusion 的新手,我建议您使用 v1.5 模型。

如何训练新模型?

使用稳定扩散的一个优点是您可以完全控制模型。如果需要,您可以创建具有独特风格的自己的模型。训练模型的两种主要方法:(1) Dreambooth 和 (2) 嵌入。

Dreambooth 被认为更强大,因为它微调了整个模型的权重。嵌入保持模型不变,但会找到描述新主题或风格的关键词。

您可以在 dreambooth 文章中使用 Colab notebook 进行试验。

负面提示

你把你想看到的东西放在提示中。你把你不想看到的东西放在否定提示中。并非所有 Stable Diffusion 服务都支持否定提示。但它对v1模型很有价值,对v2模型是必须的。初学者使用通用的否定提示并没有什么坏处。阅读有关负面提示的更多信息:

- 否定提示如何工作?

- 如何使用否定提示?

如何控制图像构图?

稳定扩散技术正在迅速改进。有几种方法。

图像到图像

您可以要求 Stable Diffusion 在生成新图像时大致跟随输入图像。这称为图像到图像。下面是使用鹰的输入图像生成龙的示例。输出图像的合成遵循输入。

输入图像

输出图像

控制网

ControlNet 同样使用输入图像来引导输出。但它可以提取特定信息,例如人体姿势。下面是使用 ControlNet 从输入图像复制人体姿势的示例。

输入图像

输出图像

除了人体姿势,ControlNet 还可以提取其他信息,例如轮廓。

图像深度

Depth-to-image 是另一种通过输入图像控制构图的方法。它可以检测输入图像的前景和背景。输出图像将遵循相同的前景和背景。下面是一个例子。

输入图像

输出图像

下一步

您已经完成了新手指南的第一个教程!检查其余的。

这是初学者指南系列的第 1 部分。阅读第 2 部分:提示构建。阅读第 3 部分:修复。阅读第 4 部分:模型。