来自用户的帖子和评论之类的内容很棒,但有时它们可能是有毒的、种族主义的和仇恨的。我们绝对不希望在我们的应用程序中出现这种情况。要解决这个问题,我们可以使用基于 AI 的工具 Cohere。Cohere 是一种最先进的语言模型 API,可以帮助我们调整应用程序中的内容。基本上,我们可以将用户的文本发送到 Cohere,然后我们将返回该文本的分类。分类可以是良性的或有毒的、仇恨的、种族主义的等。在本教程中,我们将向您展示如何使用 Cohere 来管理您的应用程序中的内容,这样您就可以在应用程序发布之前从中删除有毒内容!

让我们开始吧

首先,我们将前往 Cohere 并创建一个帐户。创建帐户后,我们将获得一个 API 密钥。我们稍后将在我们的应用程序中需要此 API 密钥。您可以在此处执行此操作:https://cohere.ai/

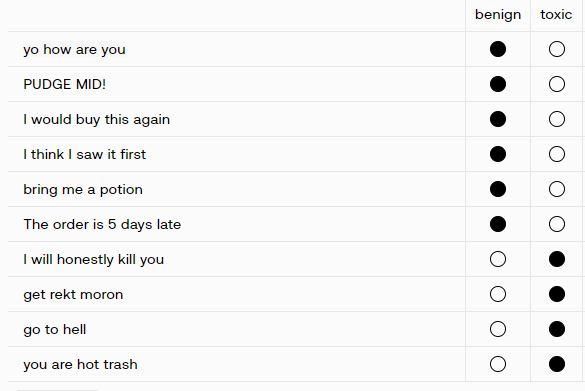

接下来,我们可以看看 Cohere 游乐场。它非常适合测试您的想法和开始一个项目。你有一个干净的用户界面,可以用多种语言导出你的代码。对于本教程,我们将在 Cohere Classify Playground 中添加几个示例,如下所示:

您可以看到每个示例都有一个文本和一个标签。标签可以是有毒的或良性的。通过这些示例,模型可以更好地确定新文本是否有毒。

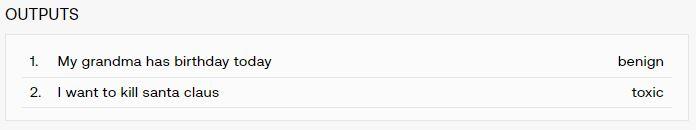

现在您已经可以使用一些输入文本测试示例字段下方的分类。您可以看到该模型已经非常擅长对文本进行分类。

那已经很酷了!但是我们如何在我们的应用程序中让它发挥作用呢?我们可以简单地按下“导出代码”按钮并选择我们想要使用的语言。您可以选择 Python、Nodejs、Go 以及 Curl 和 Cohere CLI。现在我们将使用 Pyhton。

导出后的代码如下所示:

import cohere from cohere.classify import Example co = cohere.Client('{apiKey}') response = co.classify( model='large', inputs=["My grandma has birthday today", "I want to kill santa claus"], examples= [ Example("yo how are you", "benign"), Example("PUDGE MID!", "benign"), Example("I would buy this again", "benign"), Example("I think I saw it first", "benign"), Example("bring me a potion", "benign"), Example("The order is 5 days late", "benign"), Example("I will honestly kill you", "toxic"), Example("get rekt moron", "toxic"), Example("go to hell", "toxic"), Example("you are hot trash", "toxic") ]) print('The confidence levels of the labels are: {}'.format(response.classifications)) 确保安装了 Cohere 客户端包。如果没有,您可以借助 python 包管理器 PIP 来完成此操作:

pip install cohere您可以动态地将inputs字段更改为用户的内容。请注意,您不必提供两个或更多输入。您也可以仅使用一个输入文本来运行它。

您可以像这样从响应中提取预测和置信度:

prediction = response.classifications[0].prediction # toxicconfidence = response.classifications[0].confidence # 0.98总之,在本教程中,您学习了如何使用 Cohere 来管理应用程序中的内容。您还遇到了 Cohere Python 客户端,以及如何使用它向 Cohere 发送文本输入并取回该文本的分类。您可以使用此分类来决定您的应用中是否允许该内容。

谢谢你!– AI未来百科 ; 探索AI的边界与未来! 懂您的AI未来站